【新智元導(dǎo)讀】在各種Diffusion「AI大畫家」中學(xué)習(xí)一番之后,這款全能型Diffusion要完成AIGC界的「大一統(tǒng)」!

Diffusion模型的最新進(jìn)展在許多生成任務(wù)中樹立了一個(gè)令人印象深刻的里程碑。諸如DALL·E 2、Imagen和Stable Diffusion(SD)等引人矚目的工作,引起了學(xué)術(shù)界和工業(yè)界的極大興趣。

不過,雖然這些模型表現(xiàn)驚艷,但基本都是專一于某一類任務(wù),比如由給定文本生成圖像,而對(duì)于不同類型的任務(wù),則往往需要專門單獨(dú)訓(xùn)練,或重新構(gòu)建新模型。

那么能不能在前人基礎(chǔ)上搞一個(gè)「全能型」的Diffusion,實(shí)現(xiàn)AIGC模型的大一統(tǒng)呢?有人就在努力沿著這個(gè)方向進(jìn)行探索,并已經(jīng)取得了進(jìn)展。

這個(gè)來(lái)自伊利諾伊大學(xué)厄巴納-香檳分校、得克薩斯大學(xué)奧斯汀分校的聯(lián)合團(tuán)隊(duì),試圖將現(xiàn)有的單流Diffusion擴(kuò)展為多流網(wǎng)絡(luò),稱為Versatile Diffusion(VD),這是第一個(gè)統(tǒng)一的多流多模態(tài)Diffusion框架,是邁向通用生成性人工智能的一步。

論文地址:https://arxiv.org/abs/2211.08332

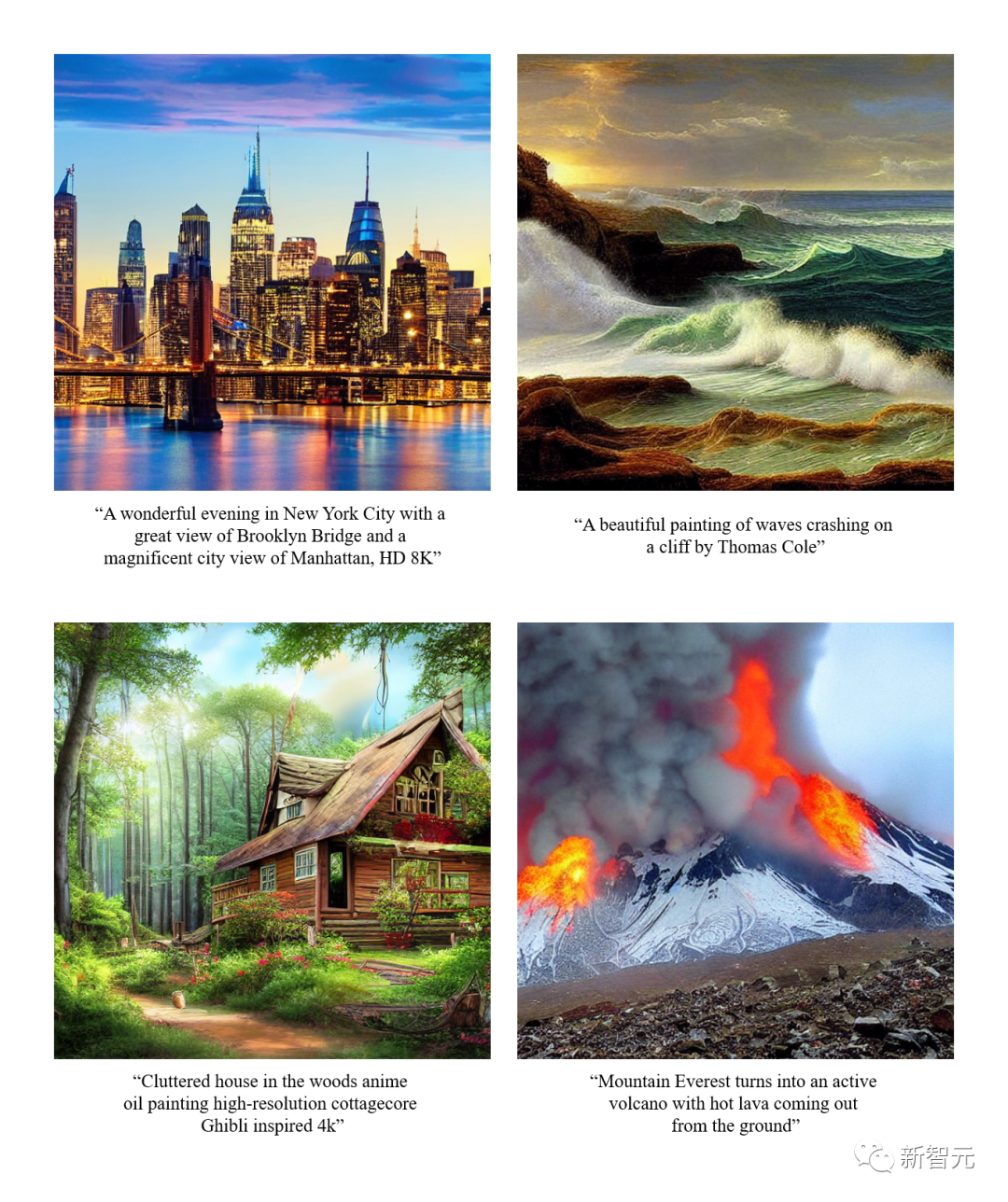

Versatile Diffusion除了普通的文字生成圖像功能之外,還可以輸入圖像生成類似圖像,輸入圖像生成文字,輸入文字生成相似文字,圖片語(yǔ)義解耦編輯,輸入圖像及文字生成視頻,根據(jù)隱空間編輯圖像內(nèi)容等等。

未來(lái)的版本還將支持更多的模式,如語(yǔ)音、音樂、視頻和3D。

據(jù)論文介紹,現(xiàn)已證明VD及其基礎(chǔ)框架具有以下優(yōu)勢(shì):

a) 可以以具有競(jìng)爭(zhēng)力的高質(zhì)量處理所有子任務(wù)。

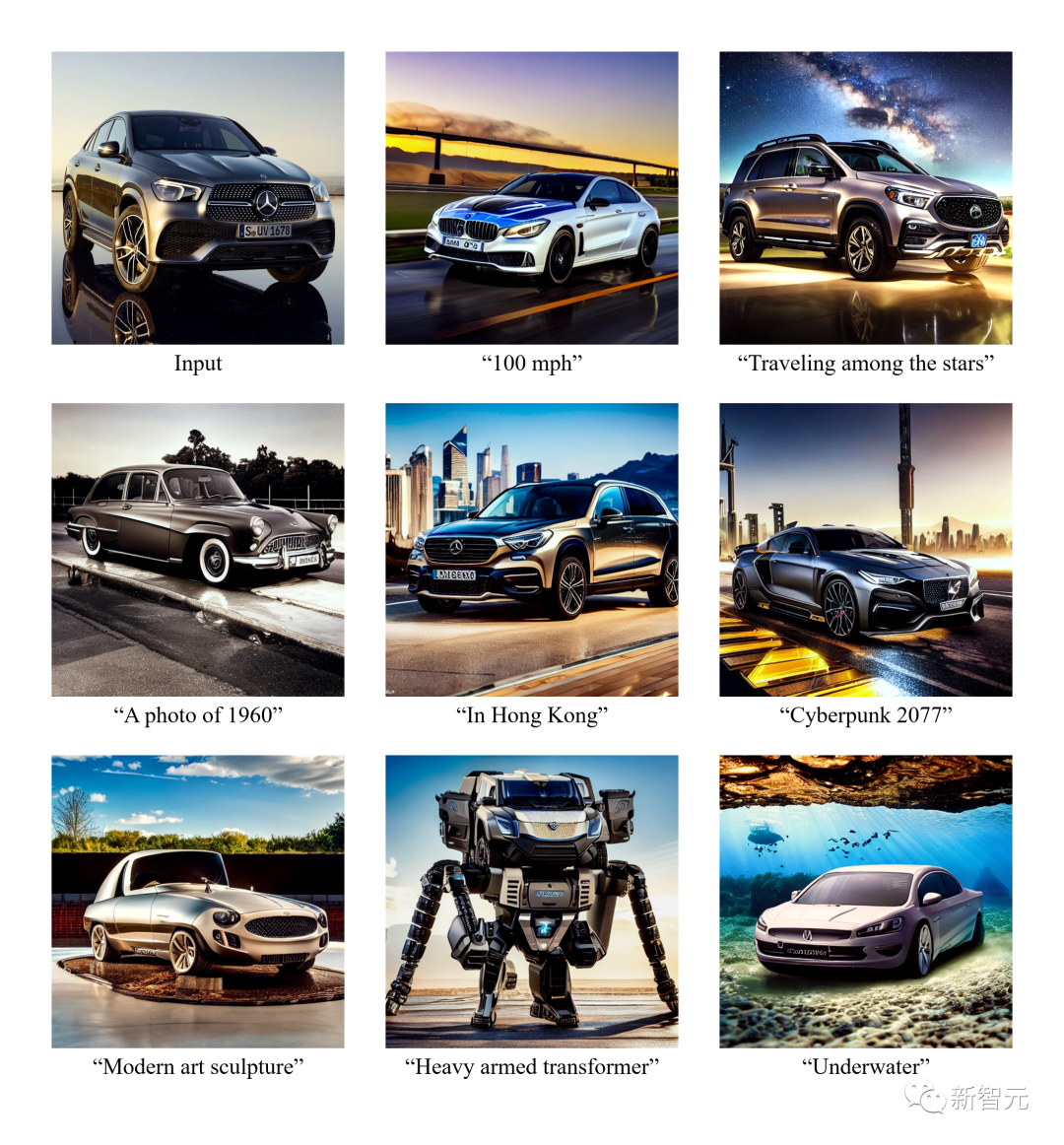

b) 支持新的擴(kuò)展和應(yīng)用,如圖形風(fēng)格和語(yǔ)義的分離、圖像-文本雙引導(dǎo)生成等。

c) 通過這些實(shí)驗(yàn)和應(yīng)用,為生成的輸出提供了更豐富的語(yǔ)義洞察力。

在訓(xùn)練數(shù)據(jù)集方面,VD使用帶有自定義數(shù)據(jù)過濾器的Laion2B-en作為主要數(shù)據(jù)集。

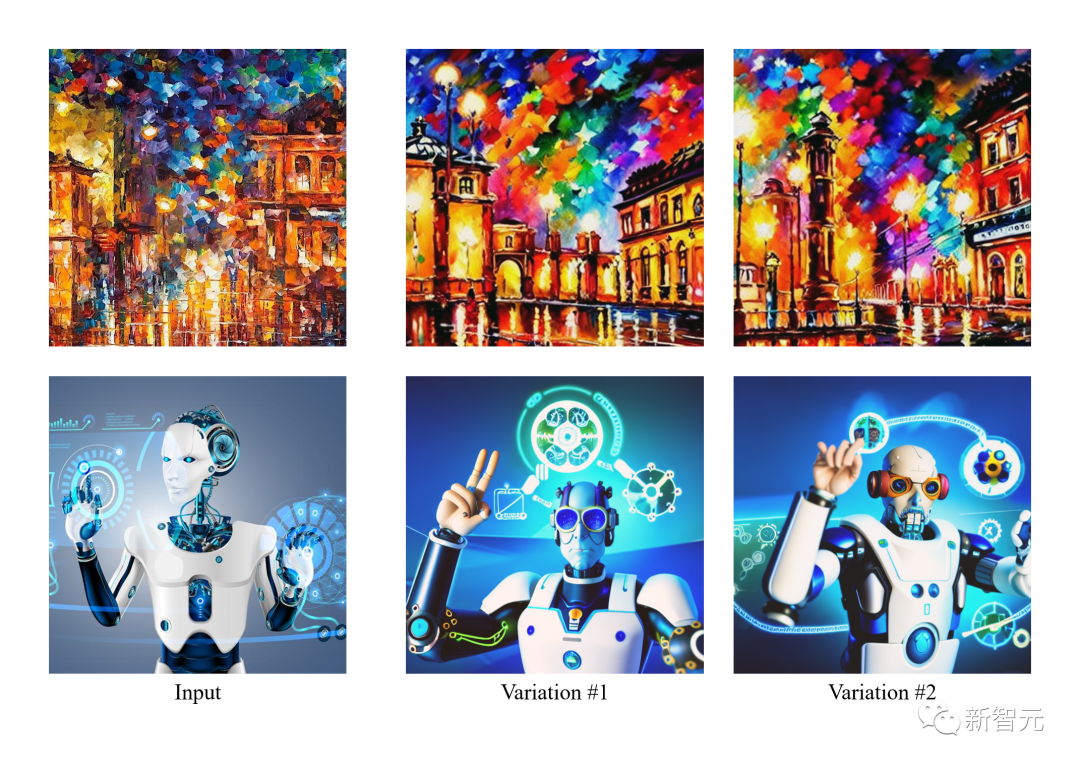

VD的一個(gè)令人興奮的發(fā)現(xiàn)是,它可以從語(yǔ)義中增強(qiáng)或減少圖像風(fēng)格,而無(wú)需進(jìn)一步監(jiān)督。

這樣的現(xiàn)象激發(fā)作者去探索一個(gè)全新的領(lǐng)域,其中,風(fēng)格和語(yǔ)義之間的分離可以發(fā)生在具有任意風(fēng)格和任意內(nèi)容的圖像上。

作者表示,他們是第一個(gè)探索:a)在沒有領(lǐng)域規(guī)范的情況下,對(duì)自然圖像的語(yǔ)義和風(fēng)格進(jìn)行解讀;b)擴(kuò)散模型潛在空間上的語(yǔ)義和風(fēng)格分解的團(tuán)隊(duì)。

在下圖中,作者首先生成輸入圖像的變體,然后以語(yǔ)義(左邊)或風(fēng)格(右邊)為重點(diǎn)對(duì)其進(jìn)行操作。

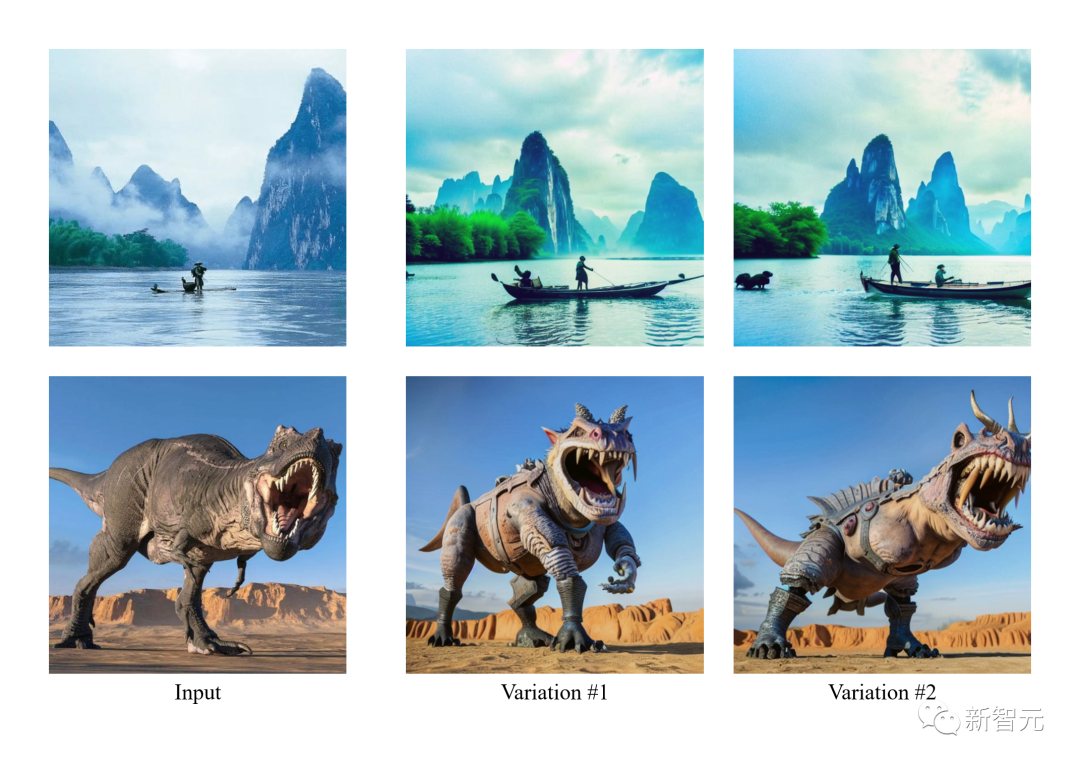

由于VD同時(shí)支持圖像到文本和文本到圖像,因此作者團(tuán)隊(duì)第一次嘗試了通過以下步驟從文本提示的角度編輯圖像:a)將圖像轉(zhuǎn)換成文本,b)編輯文本,c)將文本轉(zhuǎn)換回圖像。

在實(shí)驗(yàn)中作者從圖像中刪除了描述的內(nèi)容,然后用這種圖像-文本-圖像(I2T2I)范式添加新的內(nèi)容。與繪畫或其他需要物體位置作為輸入的圖像編輯方法不同,VD的I2T2I不需要掩碼,因?yàn)樗梢园凑罩噶钭詣?dòng)定位和替換物體。

不過,I2T2I的輸出圖像與輸入圖像的像素不一致,這是由于圖像到文本的語(yǔ)義提煉和文本到圖像的內(nèi)容創(chuàng)建造成的。

在下圖的展示中,輸入的圖像首先被翻譯成prompt,然后用減法(紅框)和加法(綠框)對(duì)prompt進(jìn)行編輯。最后,編輯后的prompt被翻譯成圖像。

此外,他們也是第一個(gè)探索基于給定的文字去生成相似文字的團(tuán)隊(duì)。

具體來(lái)說(shuō),文中提出的VD框架是一個(gè)多流網(wǎng)絡(luò),有各種類型的數(shù)據(jù)作為輸入和背景。

VD多流多模態(tài)diffusion框架繼承了LDM/SD的優(yōu)點(diǎn),具有可解釋的潛在空間、模態(tài)化結(jié)構(gòu)和較低的計(jì)算成本。

VD可以聯(lián)合訓(xùn)練多個(gè)流,每個(gè)流代表一個(gè)跨模式的任務(wù)。其核心設(shè)計(jì)是diffuser網(wǎng)絡(luò)內(nèi)的分組、共享和交換協(xié)議,使框架適應(yīng)所有支持的任務(wù)和其他任務(wù)。

diffuser分為三組:全局層、數(shù)據(jù)層和語(yǔ)境層。全局層是時(shí)間嵌入層,數(shù)據(jù)層是剩余塊,而語(yǔ)境層是交叉關(guān)注。

這種分組與層的功能相對(duì)應(yīng)。當(dāng)處理多個(gè)任務(wù)時(shí),全局層在所有任務(wù)中共享。數(shù)據(jù)層和語(yǔ)境層包含多個(gè)數(shù)據(jù)流。每個(gè)數(shù)據(jù)流都可以根據(jù)當(dāng)前的數(shù)據(jù)和上下文類型進(jìn)行共享或交換。

比如,當(dāng)處理文本-圖像請(qǐng)求時(shí),diffuser使用圖像數(shù)據(jù)層與文本語(yǔ)境層。當(dāng)處理圖像變異任務(wù)時(shí),則使用圖像數(shù)據(jù)層與圖像語(yǔ)境層。

單個(gè)VD流程包含一個(gè)VAE、一個(gè)diffuser和一個(gè)語(yǔ)境編碼器,在一個(gè)數(shù)據(jù)類型(如圖像)和一個(gè)語(yǔ)境類型(如文本)下處理一個(gè)任務(wù)(如文本轉(zhuǎn)圖像)。

Versatile Diffusion的多流結(jié)構(gòu)如下圖所示:

研究人員基于Versatile Diffusion,進(jìn)一步提出了一個(gè)通用的多流多模態(tài)框架,其中包括VAE、上下文編碼器和包含三層(即全局、數(shù)據(jù)和語(yǔ)境層)的diffuser。

VD使用已被廣泛采用的交叉關(guān)注的UNet作為diffuser網(wǎng)絡(luò)的主要架構(gòu),將層分為全局層、數(shù)據(jù)層和語(yǔ)境層。其中數(shù)據(jù)層和語(yǔ)境層有兩個(gè)數(shù)據(jù)流來(lái)支持圖像和文本。

對(duì)于圖像數(shù)據(jù)流,遵循LDM并使用殘差塊(ResBlock),其空間維度逐漸減少,通道數(shù)逐漸增加。

對(duì)于文本數(shù)據(jù)流,利用新的全連接殘差塊(FCResBlock),將768維的文本潛伏向量擴(kuò)展為320*4的隱藏特征,并遵循類似的通道增加范式,再利用GroupNorms、SiLU和跳過連接,就像普通的ResBlock一樣。

如上圖所示,F(xiàn)CResBlock包含兩組全連接層(FC)、分組歸一化(GN)和sigmoid線性單元(SiLU)。x是輸入文本潛伏代碼,t是輸入時(shí)間嵌入,hi是中間特征。

對(duì)于語(yǔ)境組,圖像和語(yǔ)境流都采用交叉注意力層,其中內(nèi)容嵌入通過投影層、點(diǎn)積和sigmoids來(lái)操作數(shù)據(jù)特征。

VD采用此前的潛在擴(kuò)散模型(Latent Diffusion Model,LDM)的自編碼器-KL作為圖像數(shù)據(jù)VAE,采用Optimus作為文本數(shù)據(jù)VAE。Optimus由BERT文本編碼器和GPT2文本解碼器組成,可以將句子雙向轉(zhuǎn)化為768維正態(tài)分布的潛在向量。

同時(shí),Optimus還以其可重構(gòu)和可解釋的文本潛空間顯示出令人滿意的VAE特性。因此選擇Optimus作為文本VAE,因?yàn)樗浅7隙嗔鞫嗄B(tài)框架的前提條件。

語(yǔ)境編碼器(Context Encoder):

VD使用CLIP文本和圖像編碼器作為上下文編碼器。與只使用原始文本嵌入作為語(yǔ)境輸入的LDM和SD不同,VD使用歸一化和投影嵌入,使文本和圖像的CLIP對(duì)比損失最小化。

實(shí)驗(yàn)表明,上下文類型之間更接近的嵌入空間有助于模型快速收斂,表現(xiàn)更好。類似的結(jié)論也可以在DALL·E 2中實(shí)現(xiàn),DALL·E 2用額外的投影層來(lái)微調(diào)文本到圖像的模型,以最小化文本和圖像嵌入之間的差異,用于圖像變化。

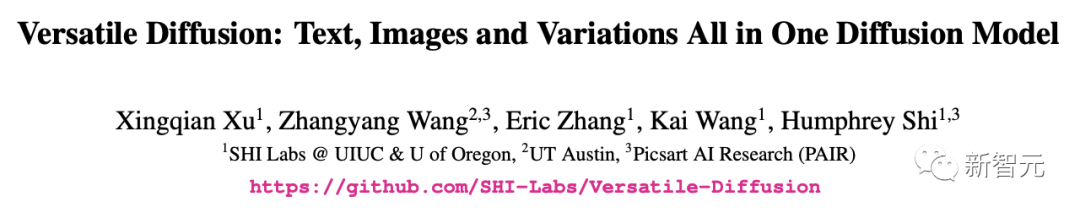

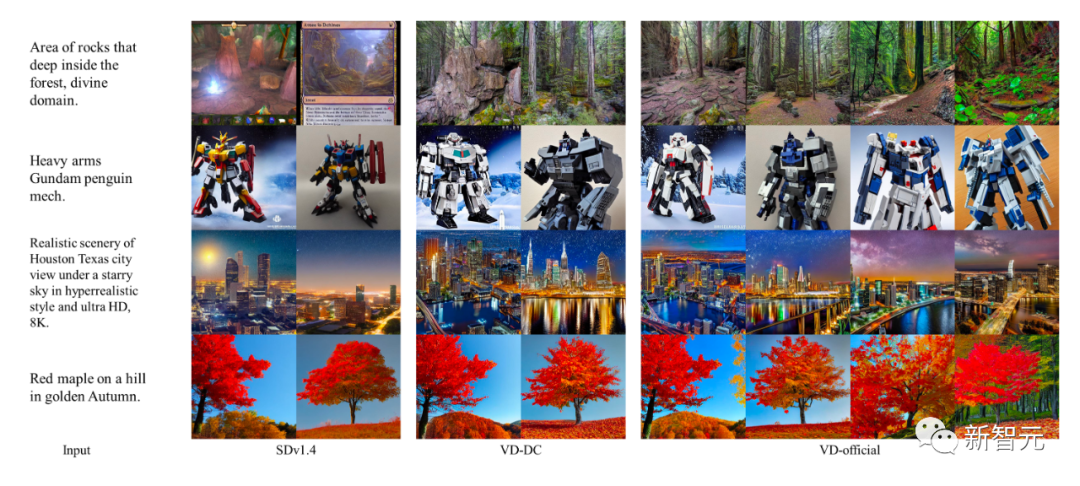

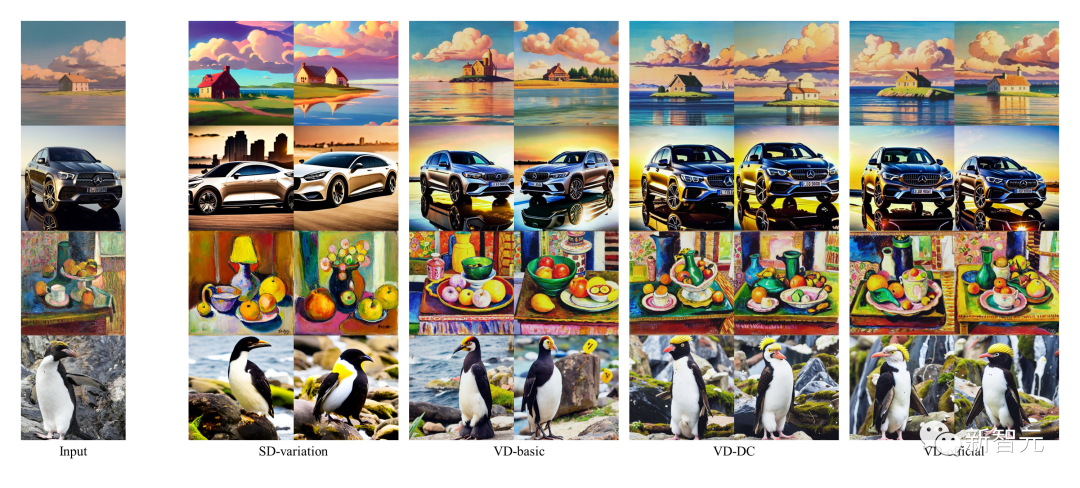

作者將早期的單任務(wù)模型作為基線模型,并將VD的結(jié)果與這些基線進(jìn)行比較。其中,SDv1.4作為文本到圖像的基線模型,SD-variation用于圖像-變體,而BLIP用于圖像-文本。

同時(shí),作者還對(duì)不同的VD模型進(jìn)行了定性比較,其中VDDC和VD-of?cial用于文本到圖像,所有三個(gè)模型用于圖像變體。

其中SD和VD的圖像樣本是用受控的隨機(jī)種子生成的,以便更好地檢查質(zhì)量。

雖然DALLE 2和Imagen在這些任務(wù)上也取得了SOTA,但由于沒有公開的代碼或訓(xùn)練細(xì)節(jié),因此作者跳過了對(duì)它們的比較。

結(jié)果顯示,多流程結(jié)構(gòu)和多任務(wù)訓(xùn)練可以幫助VD捕獲上下文語(yǔ)義并更精確地生成輸出,并出色地完成了所有的子任務(wù)。

此外,由VD生成的圖像標(biāo)注還包含了一些創(chuàng)造性的詞語(yǔ)。相比起來(lái),BLIP的生成就很短,缺乏對(duì)細(xì)節(jié)的描述。

-

作者介紹了Versatile Diffusion(VD),一個(gè)多流的多模態(tài)diffusion網(wǎng)絡(luò),在一個(gè)統(tǒng)一的模型中解決了文本、圖像和變化。在VD的基礎(chǔ)上,作者進(jìn)一步介紹了一個(gè)通用的多流多模態(tài)框架,其中可以涉及新的任務(wù)和領(lǐng)域。

-

通過實(shí)驗(yàn),作者發(fā)現(xiàn)VD在所有支持的任務(wù)上都能產(chǎn)生高質(zhì)量的輸出,其中VD的文本到圖像和圖像到變體的結(jié)果能更好地捕捉上下文中的語(yǔ)義,VD的圖像到文本的結(jié)果具有創(chuàng)造性和說(shuō)明性。

-

鑒于VD的多流多模態(tài)屬性,作者引入了新穎的擴(kuò)展和應(yīng)用,可能會(huì)使從事這項(xiàng)技術(shù)的下游用戶進(jìn)一步受益。

伊利諾伊大學(xué)厄巴納-香檳分校的IFP團(tuán)隊(duì)是由黃煦濤教授在80年代創(chuàng)立的,起初是貝克曼高級(jí)科學(xué)和技術(shù)研究所的圖像形成和處理小組。

多年來(lái),IFP一直致力于圖像以外的研究和創(chuàng)新,包括圖像和視頻編碼、多模態(tài)人機(jī)交互、多媒體注釋和搜索、計(jì)算機(jī)視覺和模式識(shí)別、機(jī)器學(xué)習(xí)、大數(shù)據(jù)、深度學(xué)習(xí)和高性能計(jì)算。

目前IFP的研究方向是通過協(xié)同結(jié)合大數(shù)據(jù)、深度學(xué)習(xí)和高性能計(jì)算來(lái)解決多模態(tài)信息處理的問題。

此外,IFP在人工智能領(lǐng)域的頂級(jí)會(huì)議上獲得了多篇最佳論文,并在許多國(guó)際競(jìng)賽中獲勝,包括首屆NIST TrecVID、首屆ImageNet挑戰(zhàn)賽和首屆人工智能城市挑戰(zhàn)賽。

有趣的是,自黃教授1960年代開始在麻省理工學(xué)院任教以來(lái),IFP小組的「成員」甚至包括朋友、學(xué)生、學(xué)生的學(xué)生、學(xué)生的學(xué)生,甚至是學(xué)生的學(xué)生的學(xué)生。

https://arxiv.org/abs/2211.08332

https://github.com/SHI-Labs/Versatile-Diffusion

https://weibo.com/1948301550/Mh9jE9iV8